手机版 欢迎访问人人都是自媒体网站

之所以选择数据这个专题作为第一篇,是因为我深信数据是基础的基础,是谈一切方法论的依据和根基所在。尽管相信数据是必须的,但我们也常常掉在数据的“坑”里。下面列举一些在工作中我曾遇到过的数据使用上的问题和错误,供大家参考。

您是否有过这样的体会,面对着海量的报表数据,一阵眼晕,顿觉无处着眼,每个字节似乎都在“跳动”,仿佛身处迷雾之中?反正我有,并且常常有(今日头条改名“字节跳动”,我脑海中浮出来的居然是这样的报表)。

报表上海量的数据往往“看上去好像有用”,或者某一次被用到过,就上了周报、月报。随着时间的推移,数据越堆越多,渐渐成为一片汪洋大海。这事实上也许没什么帮助。

首先,这会消耗数据团队的人力或技术资源来生成这些数据,消耗读者的大量时间精力来阅读这样的数据,然后往往并没有相应的产出。

其次,更糟糕的是,这样的“汪洋大海”会使真正值得被注意的数据彻底淹没,并得不到关注。数据太多了,大家往往干脆都不看,不是吗?

数据是拿来用的,不用的就是无用数据。建议如下:

1. 根据会实际执行的具体动作而定制数据需求。

2. 定期回顾数据报表,哪些很久没有被使用了,可以定期清理去除。当然,存档性的基础数据越全越好,但也应尽量减少数据冗余,以减低数据一致性风险。

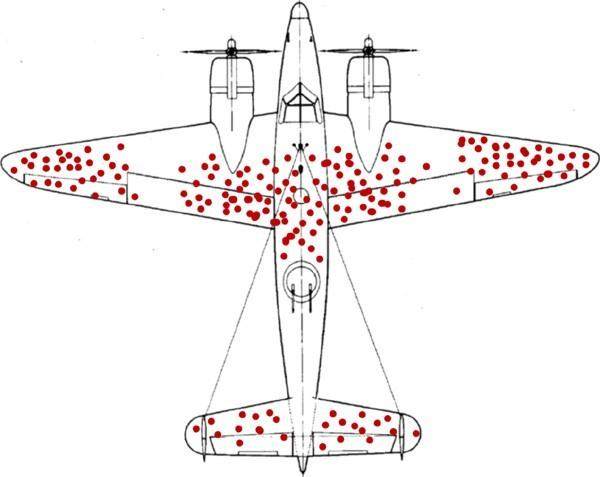

二、幸存者偏差统计学家亚布拉罕.沃德在二战中受聘于美军一个研究小组,从归航的幸存战机机身上残留的弹痕,倒推出被击落的战机的“致命部位”,找到战机的薄弱环节。下图是他的统计图:

数据统计不会骗人,该图表明:应该在机翼和座舱前后加强防护能力。

然而,这结论真的对吗?请思考一分钟。

如前所述,以上的统计,主要是针对返航维修的战斗机所做的统计。而二战时期的战斗机,发动机和螺旋桨基本都在飞机的机头部位,我们应该可以想到,一旦飞机的心脏-机头被击中,根本没机会返航,直接成了残骸,而残骸往往也很难定位被击中部位。统计图中机头没有红点,很容易错误地结论机头不需要额外加强,而这样的错误,代价是惨重的。

这就是“幸存者偏差”。该现象指的是只能看到经过某种筛选而产生的结果,而没有意识到筛选的过程,因此忽略了被筛选掉的关键信息。

实际的工作中我们也常遇到此类问题,例如:侧重局部数据分析,而统计局部选取不甚合理,与整体状况有较大差异,从而得出错误结论。或者,某品类转化较好,就结论其更符合消费者需求,而其实只是该品类获得了大部分资源。

三、过度反应于数据小幅波动有时对环比做统计,看到流量增减了3%,就花很多时间去做分析,却得不出有价值结论。

这世界唯一永恒不变的就是变化。要对数据波动合理性有一个判断,超出什么幅度才代表可能会引起业务后果的异常状况(可以参考统计学相关知识),设立合适的警戒阈值,只有超出了上下限才触发一次分析。这样可以有效节省数据团队资源,也可以让自己专注于正确的事情。

建立数据波动警戒阈值时,建议考虑如下两点:

1. 充分参考历史数据情况,观察每一次引发数据波动的值得关注的“事件”带来对波动幅度,用统计学对方法确定警戒阈值。

2. 充分考虑正常时令因素或社会因素引起的波动,把这个波动带进去作为正常状态的基线,基线基础上进一步的超阈值波动才值得进行分析。

四、忽略趋势性数据与上面提到的“过度反应”情况相反,有时小幅的数据持续性变化(同向的增减),可能在揭示着背后的某些必然性因素。如果观察到趋势性现象(连续5个或7个同向点,基于数据对应的事情本身有多关键),哪怕幅度微小,也应当引起重视,触发分析。详细参见本系列第一篇文章相关内容。

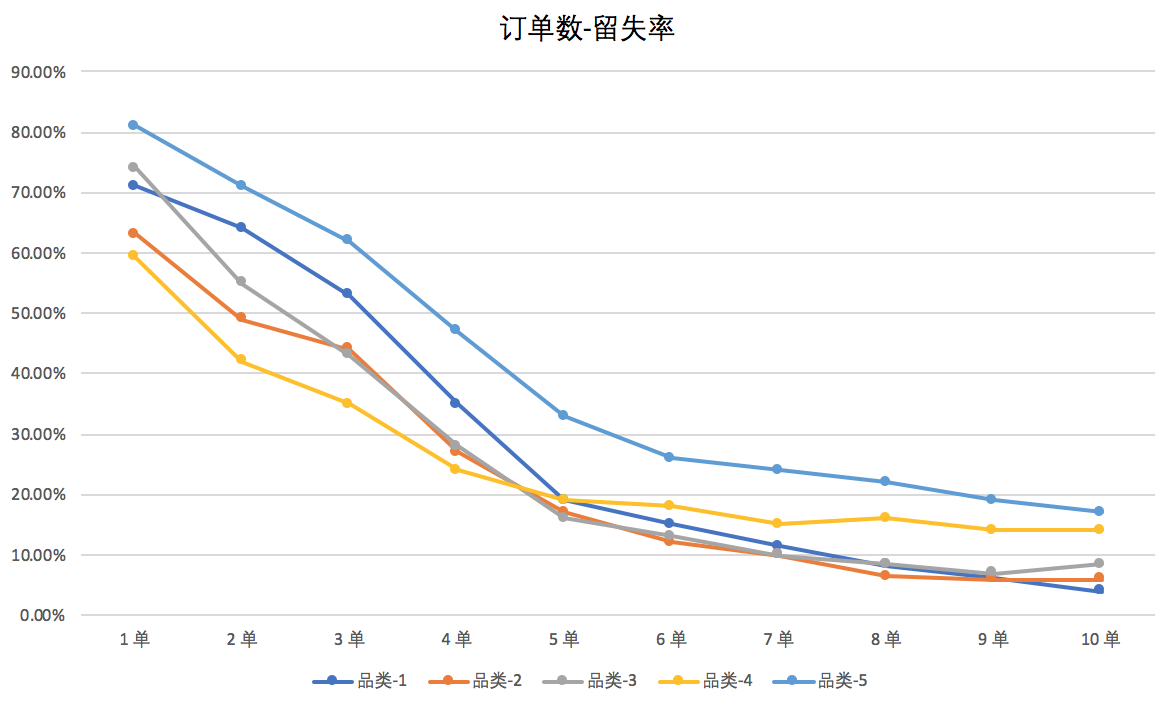

五、数据扭曲很多时候数据受到多种未被统计到的因素影响而产生偏差。例如,下图是某互联网公司分析订单与用户自然流失关系的折线图。

从上图不难看出,大致在4~6单之间流失率出现拐点,因品类而略有不同。于是,我们不难结论——第5单是留存的魔法数字。也就是说,如果用户下到第5单,留存会进入相对稳定的状态。于是,运营团队据此立项,通过每单补贴,或设定任务目标激励,推动用户从新客一路转化到5单。

大家先思考一下,这样做有什么问题?

Copyright © 2018 DEDE97. 织梦97 版权所有 京ICP